Kaspersky: una ricerca rivela come l’Intelligenza Artificiale è arrivata sul dark web

Si parla di AI e dell’uso illecito di ChatGPT in 3.000 post sul Dark Web, questo quanto emerge dal nuovo studio condotto da Kaspersky.

L’intelligenza artificiale permea ogni settore produttivo, ed è quindi inevitabile il suo impiego anche in quello dei crimini informatici, come ha rivelato lo studio pubblicato oggi dalla società di sicurezza informatica Kaspersky.

3.000 post sul dark web parlano di come usare ChatGPT per delinquere

Dati rubati, account fasulli e creati in sequenza, ma anche violazione dei limiti imposti dalle case di produzione e molto altro, sono i temi discussi nei forum nel lato oscuro del web.

Lo ha rilevato la compagnia di sicurezza informatica Kaspersky che ha pubblicato un report dettagliato sulle tendenze e gli argomenti trattati a proposito di AI nel dark web.

Non solo ChatGPT, anche gli altri sistemi di intelligenza artificiale, denominati large language model (LLM), sono oggetto delle discussioni tra utenti sulle piattaforme del dark web.

Li ha identificati Kaspersky Digital Footprint Intelligence che ha rilevato quasi 3000 post sul dark web dedicati alle modalità d’uso dei chatbot per portare avanti attività illegali.

Gli autori dei post sono intenzionati a usare la tecnologia AI per sfruttarla a proprio vantaggio. In particolare, rileva l’indagine, si cercano i modi per creare versioni alternative dei chatbot addestrandoli per scopi malevoli, o per violarli, i cosiddetti jailbreak. Questo termine indica la possibilità di bypassare le restrizioni dell’addestramento dei bot per ottenere informazioni potenzialmente pericolose o semplicemente sconvenienti.

L’AI è il nuovo tormentone, anche sul dark web

Non solo il web in chiaro, anche il dark web, i meandri della rete che ospitano ogni sorta di attività illegale o ai limiti della legalità, è ossessionato dall’intelligenza artificiale.

Oltre a cercare di sbloccare funzioni pericolose, i criminali si dedicano anche ai servizi che offrono la creazione automatizzata in massa di account sulle principali piattaforme AI.

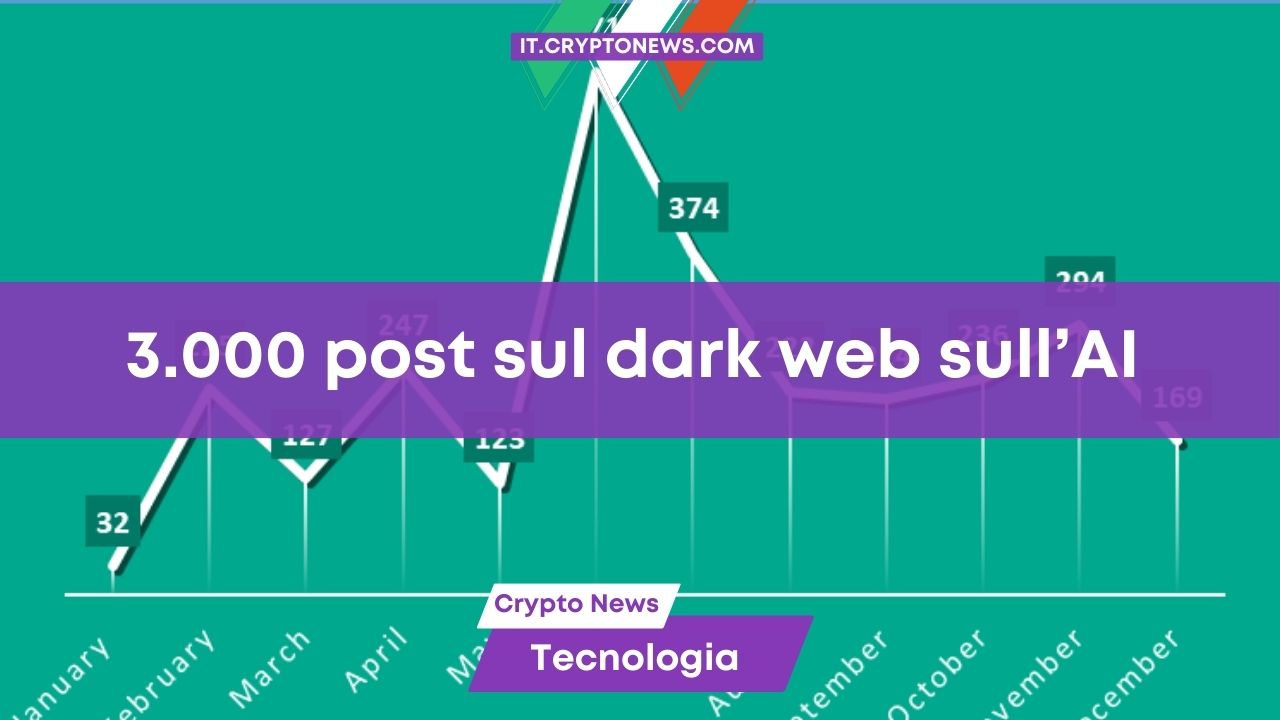

L’anno dell’intelligenza artificiale, il 2023, è stato anche il periodo in cui si sono intensificate le chat a tema AI sul dark web. I circa 3.000 post identificati da Kaspersky Digital Footprint Intelligence coprono vari temi, dall’uso di ChatGPT per scopi illegali o per creare e ottenere strumenti basati su tecnologie AI.

Marzo è stato il momento in cui sul dark web non si parlava d’altro, da quanto emerge dalla ricerca. Ma il chiacchiericcio sull’AI nel forum illegali non si è esaurito e l’interesse sull’argomento è ancora alto.

Le dinamiche delle discussioni nel dark web sull’uso di ChatGPT o di altri strumenti di AI. Fonte: Kaspersky Digital Footprint Intelligence

Non si parla di questi temi solo sul dark web ma anche sui canali Telegram che Kaspersky definisce shadow. Si dedica grande attenzione anche ai progetti malevoli denominati XXXGPT e FraudGPT, gli LLM venduti sul dark web come alternative a ChatGPT con funzionalità aggiuntive e senza le limitazioni originali.

Alisa Kulishenko, Digital Footprint Analyst di Kaspersky ha spiegato:

“Gli attori delle minacce stanno esplorando attivamente vari schemi per implementare ChatGPT e AI. Gli argomenti trattati includono spesso lo sviluppo di malware e altri tipi di uso illecito dei modelli linguistici, come l’elaborazione di dati utente rubati, il parsing di file da dispositivi infetti e altro. La popolarità degli strumenti di IA ha favorito l’integrazione delle risposte automatiche di ChatGPT o dei suoi equivalenti in alcuni forum di criminali informatici. Inoltre, gli attori delle minacce tendono a condividere jailbreak attraverso vari canali del dark web – speciali set di prompt che possono sbloccare funzionalità aggiuntive – e a escogitare modi per sfruttare strumenti legittimi, come quelli per il pentesting, basati su modelli per scopi malevoli.”

In vendita migliaia di account ChatGPT rubati

Un’altra minaccia per utenti e aziende è il mercato degli account per la versione a pagamento di ChatGPT.

Oltre a quelli dedicati allo scambio di informazioni, nel 2023 altri 3.000 post sul dark web e sui canali shadow di Telegram erano dedicati alla vendita di account ChatGPT. Si tratta di account rubati o di servizi di registrazione automatica in serie di un gran numero di account sulla piattaforma.

I post per promuovere questi servizi sono stati trovati, identici, su vari canali del dark web.

Ancora Alisa Kulishenko ha spiegato nella ricerca che gli strumenti AI non sono pericolosi di per sé, ma si sta sviluppando un filone di ricerca tra “i criminali informatici che stanno cercando di trovare modi efficienti per utilizzare i modelli linguistici, alimentando così una tendenza ad abbassare la barriera d’ingresso al cyber crime e, in alcuni casi, ad aumentare potenzialmente il numero di attacchi IT”.

La ricerca esclude che nel corso del 2024 IA generativa e chatbot possano trasformare in maniera radicale il modo in cui vengono perpetrati gli attacchi informatici. Spiega la Kulishenko che “la natura automatizzata dei cyberattacchi spesso implica difese automatizzate. Tuttavia, restare informati sulle attività degli aggressori è fondamentale per essere in vantaggio sugli avversari in termini di sicurezza informatica aziendale”.

L’evoluzione dei sistemi di protezione informatica

Questo tipo di ricerche mette in evidenza la nuova direzione intrapresa dai criminali informatici per sferrare i loro attacchi. Del resto, anche gli sviluppatori di software di sicurezza come Kaspersky Digital Footprint Intelligence devono adattare la loro risposta alle mutate esigenze.

Quel che è importante adesso, spiega la compagnia di cyber security, è sensibilizzare l’opinione pubblica sui rischi già in atto da parte dei criminali informatici. Sapere quali minacce nasconde il web e in che modo l’intelligenza artificiale è in grado di renderli più verosimili è un’arma da usare per proteggere i propri dati personali e gli altri dati sensibili.

___

Leggi anche:

- Kaspersky rivela pericoloso malware che si finge un software di mining

- I cyber-criminali attaccano gli investitori crypto con nuovi malware: ecco cosa devi sapere